RankBrain: l’évolution de l’algorithme de Google

Dans le cadre de la recherche Web, Google utilise une composante d’autoapprentissage dans son algorithme. Cette nouvelle du 15 octobre 2015 a suscité l’émoi du chercheur scientifique Greg Corrado. L’agence Bloomberg a révélé aux employés de Google que le leader des moteurs de recherche utilisait déjà cette méthode d’interprétation des requêtes utilisateurs via l’intelligence artificielle (AI). Le système correspondant, appelé « Rankbrain », a été intégré à l’algorithme du moteur de recherche déjà six mois avant la publication de l’interview. Google investit des millions dans la recherche sur l’intelligence artificielle, et ce depuis des années. Déjà en 2012, le moteur de recherche embauchait le visionnaire en technologie Raymond Kurzweil comme directeur de l’ingénierie (responsable du développement technique). En 2014 suivit l’acquisition de la start-up spécialisée en intelligence artificielle DeepMind pour environ 500 millions d’euros. Avec RankBrain, les efforts de Google sont concentrés sur le domaine de l’intelligence artificielle. Mais à quel point cette nouvelle technologie est-elle intelligente ? Et quelle répercussion a RankBrain sur le travail des exploitants de sites Internet et experts en SEO ?

Qu’est-ce que RankBrain?

Selon Corrado, RankBrain a été introduit début 2015 dans le cadre de l’algorithme Colibri de Google, mais avec des restrictions concernant les nouvelles recherches.

Selon les propos de Google, 3 milliards de recherches sont effectuées chaque jour via le moteur de recherche. Environ 15% des données d’utilisateurs sont des mots-clés et combinaisons de mots qui n’étaient auparavant pas connus du moteur de recherche, car ils comportaient soit certains dialectes, soit des phrases longues et complexes.

un mot-clé à longue traîne (mot-clé à longue queue ou Longtail Keyword en anglais) est une recherche complexe composée d’une série de mots formant une phrase complète. Au contraire, les mots-clés courts consistent en de très courtes et concises recherches. Ceci donnerait cette opposition par exemple : serveur cloud au lieu de comment fonctionne un serveur cloud ?

En 2016, l’utilisation de RankBrain a été étendue à l’ensemble de la recherche Google, afin que la technologie soit impliquée dans le traitement de toutes les recherches Google.

La mission principale de RankBrain est l’interprétation de mots-clés et phrases de recherche, dans le but de déterminer l’intention de l’utilisateur. RankBrain a été présenté dans le cadre de l’article de Bloomberg comme un système d’intelligence artificielle et d’autoapprentissage. Mais que veut dire Google par intelligence artificielle ? Et comment fonctionne RankBrain exactement ?

Machine Learning: Making Sense of a Messy World (Google via YouTube).

Intelligence artificielle : 60 années de recherche

Ce qui est certain, c’est qu’un ordinateur complètement autonome reste du domaine de la science-fiction. La recherche en matière d’intelligence artificielle a commencé il y a environ 60 ans, avec l’automatisation d’un comportement intelligent. Il n’existe à ce jour pas de définition générale du terme d’intelligence artificielle. Il en est de même pour le concept d’intelligence. La recherche en intelligence artificielle a pour date d’anniversaire l’année 1956, lorsqu’a eu lieu la conférence de Datmouth College, aux États-Unis. Le spectre de thèmes selon la demande de subvention de 1995 comprenait l’automatisation informatique, la synthèse vocale, les réseaux neuronaux, l’apprentissage de la machine ainsi que des réflexions sur l’abstraction, le hasard et la créativité. Tout ceci est résumé par John McCarthy, principal responsable de l’introduction du terme d’intelligence artificielle. L’informaticien de renom a ainsi posé les bases d’un nouveau domaine interdisciplinaire, dont l’intérêt de recherche et la demande de financement ont été établis lors la conférence de Dartmouth :

For the present purpose the artificial intelligence problem is taken to be that of making a machine behave in ways that would be called intelligent if a human were so behaving.

John McCarthy, 1955

Une définition similaire se trouve aujourd’hui dans l’encyclopédie Britannica:

Artificial intelligence (AI), the ability of a digital computer or computer-controlled robot to perform tasks commonly associated with intelligent beings.

Encyclopaedia Britannica

Le pionnier de l’informatique Alan Turing a élaboré en 1950 un dispositif expérimental pour mettre à l’épreuve l’intelligence d’une machine. Ce qu’on appelle le test de Turing est une expérience visant à évaluer la faculté d’une machine à avoir une conversation avec un humain. L’objectif est de convaincre les observateurs que la machine est capable de penser comme un humain. La machine réussit le test selon Turing si l’observateur ne peut déterminer qui est la machine et qui est l’humain.

A ce jour, le test de Turing est encore considéré comme insurmontable. Le Chatbot Eugene Gootsman a attiré une forte attention médiatique. Ce dernier a résisté au test en 2014, mais dans une configuration expérimentale différente, ce qui a suscité la contestation d’experts.

Les critiques doutent cependant de la capacité du test de Turing à prouver l’existence d’une intelligence artificielle. Le dispositif expérimental simulait enfin un divertissement interpersonnel. La capacité de langage ne résistait cependant que partiellement à l’intelligence humaine. De plus, le test de Turing vérifiait seulement si les signaux sortants de la machine étaient interprétés comme des comportements intelligents. Lorsque l’on parle d’intelligence, on peut différencier intentionnalité et conscience.

Mais dans la pratique, cette différentiation n’est pas nécessaire, ou du moins primordiale. Ici, ce sont surtout les fonctionnalités du système d’intelligence artificielle qui sont mises en avant. Cette approche pratique de la recherche en intelligence artificielle se reflète dans la définition de la chercheuse en informatique Elaine Rich :

Artificial intelligence is the study of how to make computers do things at which, at the moment, people are better.

Elaine Rich, 1983

Il y a ainsi deux différentes notions de ce qu’est l’intelligence artificielle :

- Notion d’IA forte (Strong artificial intelligence) : selon la notion d’intelligence artificielle forte, une machine doit pouvoir montrer les mêmes capacités intellectuelles qu’un humain. Outre la capacité à tirer des conclusions, ce terme comprend des concepts tels que la sensibilisation, la connaissance de soi, la conscience, la sagesse et la sensibilité. L’objectif est de recréer l’intelligence.

- Notion d’IA faible (Weak artificial intelligence) : selon le concept d’intelligence artificielle faible, les machines sont associées à un comportement intelligent chez l’homme. L’objectif est donc de simuler le comportement humain intelligent, la pensée logique, la prise de décision, la planification, l’apprentissage et la communication en utilisant des règles mathématiques.

Lorsque Google évoque son système d’autoapprentissage et d’intelligence artificielle RankBrain, il est question d’IA faible. Il s’agit d’une technologie qui trouve des solutions automatiquement face à des problèmes déjà rencontrés par des individus.

Par apprentissage d’une machine, on entend génération artificielle de savoir et d’expérience. Les systèmes d’autoapprentissage analysent de grandes quantités de données, identifiées à l’aide de modèles mathématiques, d’algorithmes, de tendances, de connexions croisées qui fonctionnent sur la base de données pronostiquées de manière autonome. Découvrez-en plus sur les systèmes d’autoapprentissage de machines et leurs possibilités d’utilisation dans le cadre de marketing online, et d’analyse Web.

avec RankBrain, il faut comprendre l’intelligence artificielle dans sa définition d’IA faible. Le système est basé sur des techniques d’apprentissage pour machines et mis en place en tant qu’algorithme pour interpréter les données des utilisateurs.

Comment fonctionne RankBrain?

RankBrain aide Google à interpréter les saisies des utilisateurs pour que le moteur puisse trouver les résultats de recherche qui répondent le mieux aux intentions de recherche des utilisateurs parmi une base de données d’environ 100 millions de giga-octets.

Déjà avec la mise à jour Colibri en août 2013, Google implémentait la recherche sémantique. Tandis que les mots-clés et combinaisons de mots étaient évalués sans rapport de sens et de manière statique avant Colibri, cette mise à jour de l’algorithme de Google a introduit l’interprétation des saisies des utilisateurs comme aspect central. Avec RankBrain, Google ajoute la recherche sémantique au système d’intelligence artificielle, qui est en mesure de consulter les connaissances acquises avant de répondre à des recherches nouvelles et uniques.

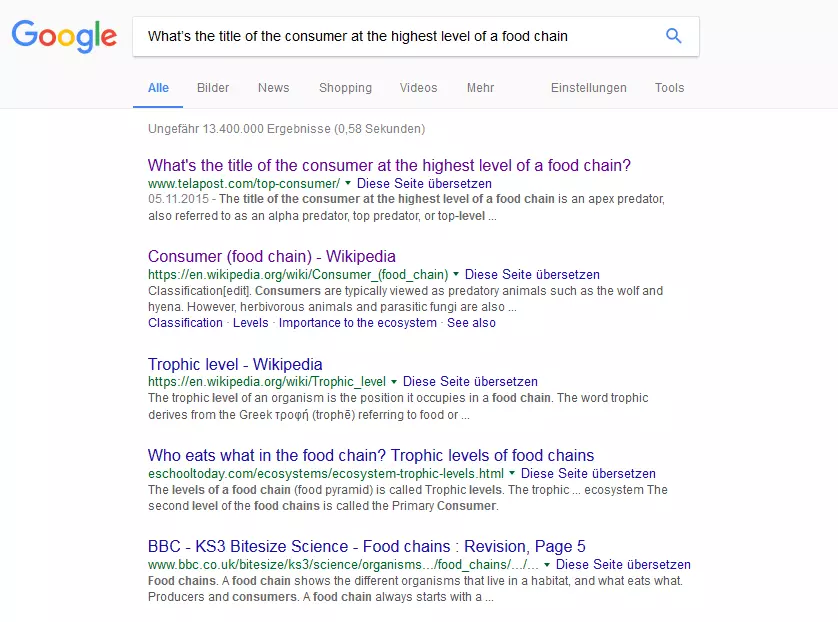

Bloomberg proposait la recherche suivante pour illustrer l’utilisation de RankBrain :

„What’s the title of the consumer at the highest level of a food chain“

Au lieu d’analyser chaque mot de la question de recherche indépendamment, RankBrain détecte la sémantique de la saisie globale de l’utilisateur et détermine ainsi l’intention de l’internaute. Malgré une longue phrase de recherche, l’utilisateur peut ainsi obtenir la réponse espérée.

En tant que système d’autoapprentissage, RankBrain recourt à son expérience avec des recherches Web effectuées précédemment, établit des liens entre les recherches et les résultats consultés, afin de déterminer les réponses convenant le mieux aux attentes de l’utilisateur. Il s’agit ici de résoudre les ambiguïtés et d’interpréter les notions inconnues jusqu’ici (néologismes par exemple). Google ne révèle toutefois pas comment le système d’intelligence artificielle répond à ce défi. Les experts en SEO supposent toutefois que RankBrain transmet des vecteurs de mots sous une forme permettant aux ordinateurs d’interpréter des contextes. Google a lancé dès 2013 un logiciel d’autoapprentissage informatique open source du nom de Word2Vec. Ce logiciel établissait des relations sémantiques entre les mots, les mesurait et les comparait. Le corpus linguistique constituait la base de cette analyse. Pour apprendre des liens de contexte entre les mots, Word2Vec créait un espace vectoriel à n dimensions, dans lequel chaque mot du corpus de texte sous-jacent (ou données d’apprentissage) est représenté en tant que vecteur. n indique ici le nombre de dimensions vectorielles imagées par un mot. Plus il y a de dimensions choisies pour les vecteurs de mots, plus le programme parcourt de relations avec d’autres mots. Dans la seconde étape, l’espace vectoriel ainsi créé est alimenté dans un réseau neuronal artificiel, permettant d’adapter un algorithme d’apprentissage pour faire en sorte que les mots utilisés dans un même contexte forment également un même vecteur de mots. La similitude entre les vecteurs de mots est calculée avec ce qu’on appelle la distance du cosinus, d’une valeur entre -1 et +1. En résumé, pour tout texte entré en input sur Word2Vec, ce dernier délivre les vecteurs de mots correspondants comme output. Ces derniers permettent une évaluation de la proximité sémantique ou de la distance des mots contenus dans le corpus. Si Word2Vec est confronté à un nouvel input, le programme est en mesure d’adapter l’espace vectoriel et de créer ainsi le rapport d’interprétation, ou de rejeter d’anciennes hypothèses grâce à l’algorithme d’apprentissage : c’est de cette façon que se forme le réseau neuronal.

les chercheurs en intelligence artificielle tentent de simuler les principes d’organisation et de traitement du cerveau humain à l’aide de réseau neuronaux artificiels. L’objectif est de développer des systèmes capables de résoudre des problèmes sans incertitudes et assumer ainsi des tâches qui étaient réservées aux humains. Les réseaux neuronaux recourent par exemple à la reconnaissance automatique de l’image avec Google.

Google n’indique pas de lien officiel entre les fonctions de Word2Vec et les composantes de l’algorithme de recherche RankBrain, mais il est probable que ces deux systèmes d’IA reposent sur des opérations mathématiques similaires.

RankBrain et l’optimisation pour les moteurs de recherche (SEO)

Plus impressionnant encore que la publication des résultats de recherche de Google dans le domaine de l’intelligence artificielle, c’est la mesure dans laquelle cela se produit. Google peut non seulement interpréter toutes les recherches Web de RankBrain depuis 2016, mais Corrado, système AI d’autoapprentissage, est intégré comme troisième facteur le plus important de l’algorithme de Google.

selon Google, RankBrain agit comme le troisième facteur le plus important dans le cadre de la recherche Web. Selon le stratège Andrey Lipattsev, le contenu et les liens retour se partagent la première et deuxième position.

Pour les exploitants de sites Internet et experts SEO, c’est surtout le regard sur les stratégies de mots-clés qui change. En tant que moteur de recherche sémantique, Google est en mesure de tirer profit de connaissances sous la forme de relations auxquelles il peut recourir afin de déterminer une interprétation contextuelle des contenus de textes et de questions de recherches. Si une page Web est bien placée dans les SERPs avec un mot-clé de recherche particulier, ceci dépend bien moins du mot-clé contenu que du contenu de la page Web associée à ce mot-clé (relié via RankBrain). L’accent n’est donc pas tant mis sur le mot-clé lui-même, mais sur la pertinence du contenu d’un site Web. C’est aussi la conclusion de l’entreprise du logiciel Searchmetrics, présente sur le marché SEO international avec une plateforme de marketing de contenu et de recherche depuis 2012, qui a effectué une série d’études sur les facteurs centraux de référencement de l’algorithme de Google. Les checklistes SEO classiques ont permis à l’essentiel de l’étude de 2016 de voir le jour. Avec le titre Rebooting Ranking-Factors, Searchmetrics entendait bien bouleverser les connaissances considérées comme acquises. Les exploitants de sites Web doivent ainsi se concentrer sur la pertinence du contenu.

grâce à RankBrain, la pertinence du contenu et l’intention de l’utilisateur sont dans le viseur de l’optimisation pour les moteurs de recherche.

Pour étudier la relation entre le classement d’une page Web et de sa pertinence par rapport aux termes de recherche correspondants, Searchmetrics utilisait dans son étude de 2016 un logiciel de Word-embedding (ou prolongement lexical) pour représenter les relations sémantiques sous la forme de vecteurs. A partir d’un ensemble de 10 000 mots-clés, l’entreprise a déterminé pour chaque terme de recherche la pertinence du contenu des premiers 20 résultats de recherche en ignorant les mots-clés. Pour ce faire, les analystes ont déterminé des scores de pertinence entre 0 et 100 pour évaluer le contenu des textes des pages Web étudiées et leurs mots-clés respectifs. Ceci a ensuite été mis en relation avec la position sur les pages de résultats de recherche.

Le résultat : les pages Web dans les premières positions des SERPs de Google se caractérisent par un contenu bien plus pertinent par rapport à la recherche que les pages moins bien classées. Selon Searchmetrics, les contenus dotés de la plus haute pertinence se trouvent entre les positions 3 et 6 des SERPs. Il convient de noter que les deux premières positions sont occupées par les pages d’entreprises, qui profitent d’un facteur de « marque » dans leur classement, selon Searchmetrics.

même les meilleurs contenus n’atteignent le sommet des SERPs que lorsque leurs pages remplissent aussi des conditions techniques. Les pages qui sont bien classées sont aussi bien accessibles par les humains que les machines. Les facteurs essentiels sont, en dehors du temps de chargement des pages et du volume des fichiers intégrés, la structure de liens d’un site Web ainsi que ses liens internes. Depuis la mise à jour mobile friendly de Google, une architecture favorisant l’utilisation mobile fait partie des prérequis pour le succès d’une page Web.

La question est de savoir comment les exploitants de sites Web vont réagir face à RankBrain et aux autres développements de Google. Une conception holistique des textes fait partie des facteurs de succès les plus importants selon Searchmetrics. Ceci fait allusion à une rédaction qui ne repose pas sur des mots-clés, mais sur les thèmes et le contenu. L’utilisateur est au centre de l’attention. Le but est de répondre à des recherches Google par un contenu pertinent. Pour cela, les exploitants de sites Internet doivent déterminer des mots-clés en fonction de l’intention de recherche et de la pertinence du contenu correspondant. Les notions clés ne peuvent être structurées ainsi qu’avec les champs de thèmes correspondants, et servent de base pour un plan de création et d’édition afin de proposer un texte riche en contenu. Apprenez-en plus sur les termes de recherche dans notre série d‘articles sur la recherche de mots-clés, d’analyse et de stratégie.