Qu’est-ce que l’Automatic Speech Recognition ?

L’Automatic Speech Recognition est une méthode de conversion automatique de la parole en texte. Les technologies ASR utilisent des procédures d’apprentissage automatique pour analyser les modèles de langage, les traiter et les afficher sous forme de texte. L’Automatic Speech Recognition se prête à une multitude d’applications, allant des assistants vocaux virtuels à la création de sous-titres pour les vidéos, en passant par la transcription de réunions importantes.

Que signifie Automatic Speech Recognition ?

Automatic Speech Recognition, en français « reconnaissance automatique de la parole », est un terme désignant le domaine de l’informatique et de la linguistique informatique. En fait, il s’agit ici de développer des méthodes qui traduisent automatiquement le langage parlé en une forme lisible par une machine. Lorsque la conversion se fait en texte, on parle également de Speech-to-Text (STT). Les méthodes ASR sont basées sur des modèles statistiques et des algorithmes complexes.

Le Taux d’Erreur de Mots (TEM) indique avec quelle précision un système ASR fonctionne. Ce taux met en relation les erreurs, c’est-à-dire le nombre de mots omis, ajoutés et mal reconnus, avec le nombre total de mots prononcés. Plus la valeur est basse, plus la précision de la reconnaissance vocale automatique est élevée. Par exemple, si le taux d’erreurs de mots est de 10 %, la précision de la transcription est de 90 %.

Comment fonctionne l’Automatic Speech Recognition ?

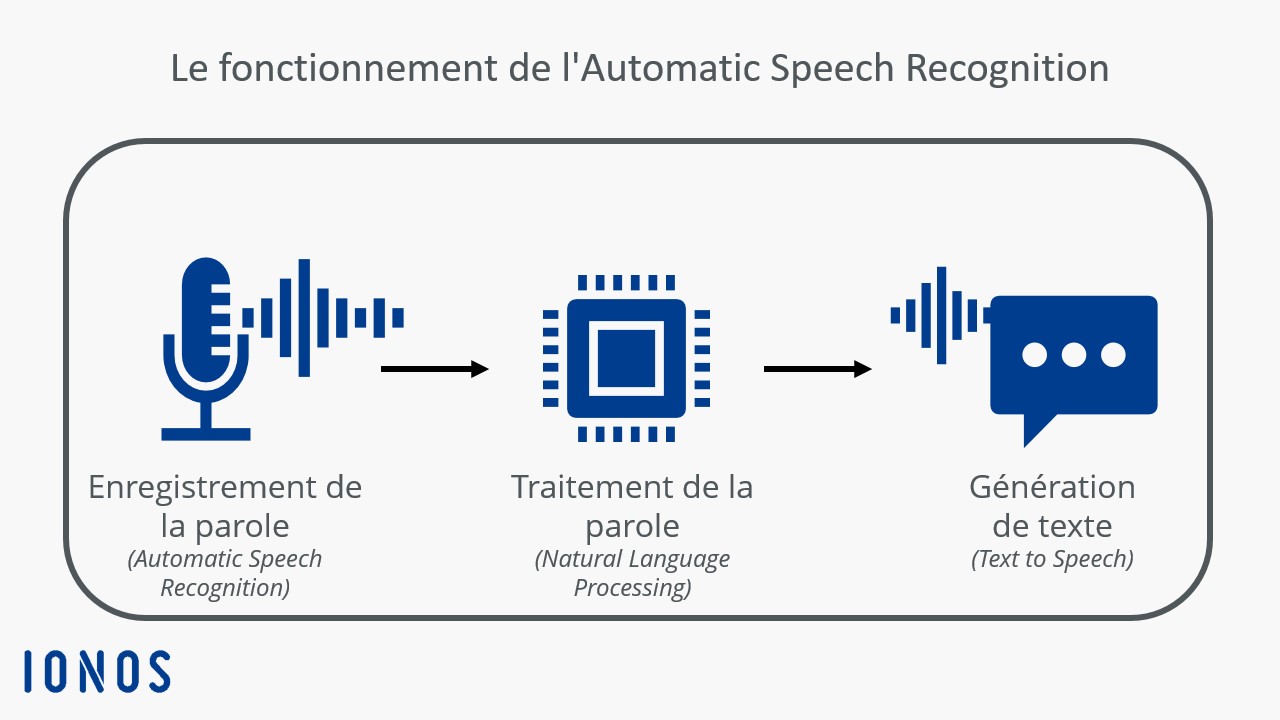

L’Automatic Speech Recognition se compose de plusieurs étapes successives qui s’imbriquent parfaitement les unes dans les autres. Voici les différentes phases du processus :

- Enregistrement de la parole (Automatic Speech Recognition) : le système capture le langage parlé via un microphone ou une autre source audio.

- Traitement de la parole (Natural Language Processing) : l’enregistrement vocal est d’abord nettoyé des bruits parasites. Ensuite, un algorithme analyse les caractéristiques phonétiques et phonémiques de la parole. Enfin, les caractéristiques saisies sont comparées à des modèles préalablement entraînés afin d’identifier des mots individuels.

- Génération de texte (Speech to Text) : le système convertit les sons reconnus en texte.

Algorithmes d’ASR : approche hybride vs Deep Learning

On distingue fondamentalement deux approches principales pour la reconnaissance automatique de la parole : alors que dans le passé, on utilisait surtout des approches hybrides classiques comme les modèles de Markov cachés, on a désormais de plus en plus souvent recours aux technologies de Deep Learning. Cette situation s’explique par le fait que la précision des modèles traditionnels stagne actuellement.

Approche hybride classique

Les modèles classiques nécessitent des données alignées de force. Cela signifie qu’ils utilisent la transcription textuelle d’un segment de parole audio pour déterminer l’endroit où certains mots apparaissent. L’approche hybride traditionnelle combine toujours un modèle de lexique, un modèle acoustique et un modèle linguistique pour transcrire la parole :

- Le modèle de lexique définit la prononciation phonétique des mots. Il est nécessaire de créer un ensemble de données ou de phonèmes pour chaque langue.

- Le modèle acoustique a pour objectif de représenter les caractéristiques sonores de la langue. Grâce à des données alignées de manière forcée, il prédit le phonème correspondant à chaque segment audio, permettant ainsi d’associer précisément chaque son à une unité linguistique.

- Le modèle linguistique apprend quelles séquences de mots sont les plus susceptibles d’apparaître dans une langue. Sa tâche consiste à prédire quels mots suivront les mots actuels et avec quelle probabilité.

Le principal inconvénient de l’approche hybride est qu’il est difficile d’augmenter la précision de la reconnaissance vocale à l’aide de cette méthode. Il est également nécessaire d’entraîner trois modèles distincts, ce qui s’avère très coûteux en temps et en argent. Comme il existe déjà de nombreuses connaissances sur la manière de créer un modèle robuste à l’aide de l’approche classique, de nombreuses entreprises optent néanmoins pour cette option.

Deep Learning avec des processus de bout en bout

Les systèmes de bout en bout possèdent la capacité de transcrire directement une série de caractéristiques acoustiques en texte. L’algorithme apprend à convertir les mots prononcés grâce à un large ensemble de données, composé de paires d’enregistrements audio de phrases spécifiques et de leurs transcriptions correctes.

Les architectures d’apprentissage profond telles que CTC, LAS et RNNT peuvent être entraînées de manière à fournir des résultats précis même en l’absence de données alignées de manière forcée, de modèle de lexique et de modèle linguistique. De nombreux systèmes de Deep Learning sont néanmoins associés à un modèle linguistique, car ce dernier peut contribuer à améliorer encore la précision de la transcription.

Dans notre article « Deep Learning vs Machine Learning », vous découvrirez en quoi les deux concepts se distinguent.

L’approche de bout en bout de l’Automatic Speech Recognition ne se distingue pas seulement par une plus grande précision que les modèles traditionnels. Elle présente également l’avantage de faciliter l’entraînement des systèmes ASR et de réduire la main d’œuvre nécessaire.

Quels sont les principaux champs d’application de l’Automatic Speech Recognition ?

Grâce notamment aux progrès réalisés dans le domaine du Machine Learning, les technologies ASR deviennent de plus en plus précises et performantes. L’Automatic Speech Recognition peut être utilisée dans de nombreux secteurs afin de réaliser des gains d’efficacité, d’augmenter la satisfaction des clients et/ou d’améliorer le retour sur investissement (ROI). Les principaux domaines d’application sont :

- Télécommunications : les centres de contact utilisent les technologies ASR pour transcrire les conversations avec les clients et les analyser par la suite. Des transcriptions exactes sont également nécessaires pour le suivi des appels et pour les solutions téléphoniques réalisées au moyen de serveurs Cloud.

- Plateformes vidéo : la création de sous-titres en temps réel sur les plateformes vidéo est devenue un standard. L’Automatic Speech Recognition s’avère également utile pour la catégorisation des contenus.

- Surveillance des médias : les API ASR permettent d’analyser les émissions de télévision, les podcasts, les émissions de radio et d’autres médias en ce qui concerne la fréquence d’apparition de certaines mentions de marques ou de thèmes.

- Vidéoconférences : les solutions de réunion telles que Zoom, Microsoft Teams ou Google Meet dépendent de la transcription exacte et de l’analyse de ce contenu pour obtenir des informations clés et prendre des mesures appropriées. L’Automatic Speech Recognition peut également être utilisée pour fournir des sous-titres en direct pour les vidéoconférences.

- Assistants vocaux : que ce soit Amazon Alexa, Google Assistant ou Siri d’Apple, les assistants vocaux virtuels sont basés sur l’Automatic Speech Recognition. Cette technologie permet aux assistants de répondre aux questions, d’effectuer des tâches et d’interagir avec d’autres appareils.

Quel est le rôle de l’intelligence artificielle dans les technologies ASR ?

L’intelligence artificielle contribue à améliorer la précision et la fonctionnalité générale des systèmes ASR. En particulier, le développement de grands modèles linguistiques a permis d’améliorer considérablement le traitement du langage naturel. Un Large Language Model (LLM) est non seulement capable de produire des textes complexes et pertinents et d’effectuer des traductions, mais reconnaît également le langage parlé. Les systèmes ASR bénéficient donc considérablement des développements dans ce domaine. En outre, l’intelligence artificielle s’avère également utile pour le développement de modèles linguistiques spécifiques aux accents.

- Créez votre site Web en un temps record

- Boostez votre activité grâce au marketing par IA

- Gagnez du temps et obtenez de meilleurs résultats

Quels sont les points forts et points faibles de l’ASR ?

Comparée à la transcription traditionnelle, la reconnaissance automatique de la parole présente certains avantages. L’un des principaux points forts des méthodes modernes de reconnaissance vocale automatique réside dans leur grande précision, due au fait que les systèmes correspondants peuvent être entraînés avec de grandes quantités de données. Cela permet d’améliorer la qualité des sous-titres ou des transcriptions et de les fournir en temps réel.

Un autre avantage important est l’augmentation de l’efficacité. L’Automatic Speech Recognition permet aux entreprises d’évoluer, d’élargir plus rapidement leur gamme de services et de les proposer à un plus grand nombre de clients. Pour les étudiants et les professionnels, les outils de reconnaissance vocale automatique facilitent la documentation de contenus audio, par exemple d’une réunion d’affaires ou d’un cours universitaire.

L’inconvénient est que les systèmes de reconnaissance vocale automatique, bien que plus précis que jamais, n’atteignent toujours pas la précision des humains. Cela est principalement dû aux nombreuses nuances de la parole. Les accents, les dialectes et les différentes tonalités, mais aussi les bruits parasites, constituent un défi particulier. Même les modèles d’apprentissage en profondeur les plus performants ne peuvent pas couvrir tous les cas particuliers. Autre problème : les technologies ASR traitent parfois des données personnelles, ce qui soulève des inquiétudes quant à la vie privée et à la sécurité des données.