Apache Spark : définition et fonctions

Apache Spark se distingue de ses prédécesseurs (Hadoop) ou de ses concurrents (PySpark) grâce à l’incroyable rapidité de ses performances, une caractéristique parmi les plus importantes dans le cadre de l’interrogation, du traitement et de l’analyse d’importants volumes de données. En sa qualité de framework big data et d’analytique en mémoire, Spark offre de nombreux avantages en matière d’analyse de données, d’apprentissage automatique, de diffusion de données et de langage SQL.

Qu’est-ce qu’Apache Spark ?

Apache Spark, le framework d’analyse de données développée par l’université de Berkeley, est aujourd’hui considérée comme l’une des plateformes de big data les plus plébiscitées au monde. Elle compte parmi les « Top-Level Projects » (projets de niveau supérieur) d’Apache Software Foundation. Ce moteur analytique permet de traiter simultanément d’importants volumes de données et d’applications d’analyse de données dans des clusters informatiques distribués. Le framework Spark a été créé pour répondre aux exigences propres au big data en matière de vitesse de calcul, d’extensibilité et d’évolutivité.

Elle propose à cette fin des modules intégrés pouvant être utilisés pour le Cloud computing, l’apprentissage automatique, les applications d’intelligence artificielle (IA) ainsi que les données graphiques et de diffusion offrent de nombreux avantages. Puissant et évolutif, ce moteur est même utilisé par d’importants fournisseurs tels que Netflix, Yahoo et eBay.

Quelles sont les particularités d’Apache Spark ?

Le moteur Apache Spark est nettement plus rapide et puissant qu’Apache Hadoop ou qu’Apache Hive. Il est cent fois plus rapide que MapReduce, développé par Hadoop, lorsque le traitement des commandes s’effectue en mémoire, et dix fois plus rapide que celui-ci lorsqu’il s’effectue sur le disque. Spark propose donc aux entreprises des performances qui leur permettent de réduire les coûts tout en améliorant leur efficacité.

La flexibilité de Spark reste toutefois son aspect le plus intéressant. Non seulement il est possible d’exécuter ce moteur de manière autonome, mais vous pouvez également l’intégrer à des clusters Hadoop gérés par YARN. Il permet en outre aux développeurs d’écrire des applications Spark dans plusieurs langages de programmation. Il peut ici s’agir de SQL, mais aussi de Python, de Scala, de R ou encore de Java.

Spark possède également d’autres particularités : vous ne devez pas l’installer sur le système de fichiers Hadoop, mais il peut très bien être utilisé avec d’autres plateformes de données telles qu’AWS S3, Apache Cassandra ou encore HBase. De plus, si vous indiquez la source des données, il est en mesure de traiter aussi bien les processus batch, comme c’est le cas sous Hadoop, que les données de flux et les différentes charges de travail, le tout avec un code presque identique. Grâce à son processus d’interrogation interactif, vous pouvez ainsi répartir les données en temps réel actuelles et plus anciennes, notamment analytiques, sur plusieurs couches du disque dur et de la mémoire, puis les traiter en parallèle.

Comment fonctionne Spark ?

Le fonctionnement de Spark est fondé sur le principe hiérarchique « primaire-secondaire », également connu sous le nom, aujourd’hui obsolète, de principe « maître-esclave ». Le pilote Spark fait donc office de nœud « maître » administré par le gestionnaire du cluster. Il contrôle les nœuds « esclaves » et transmet au client les analyses de données. Le point d’entrée SparkContext, créé par le pilote Stark, permet de répartir et de surveiller les exécutions et les interrogations ; il fonctionne de concert avec des gestionnaires de clusters comme Spark, YARN, Hadoop ou encore Kubernetes. Des Resilient Distributed Datasets (RDD, littéralement « ensembles de données distribués résilients ») sont également créés.

Spark détermine les ressources à utiliser pour l’interrogation ou le stockage des données, ou encore l’emplacement sur lequel les données interrogées doivent être transférées. Le moteur traite les données de façon directe et dynamique dans la mémoire vive des clusters de serveurs, ce qui permet de réduire la latence et d’offrir des performances extrêmement rapides. Les étapes de travail en parallèle et l’utilisation de mémoires virtuelles et physiques viennent compléter cette offre.

Apache Spark est également en mesure de traiter les données provenant de différentes mémoires de données, notamment du Hadoop Distributed File System (HDFS, littéralement « système de fichiers distribués ») et des mémoires de données relationnelles comme Hive ou les bases de données NoSQL. Il prend également en charge le traitement en mémoire ou sur disque, en fonction de la taille des ensembles de données concernés, ce qui vous permet d’améliorer vos performances.

Les RDD : des ensembles de données distribués qui résistent aux pannes

Dans Apache Spark, les Resilient Distributed Datasets constituent une base importante pour le traitement de données, qu’elles soient ou non structurées. Spark répartit ces agrégations de données qui résistent aux pannes sur des clusters de serveurs par clustering et les traite en parallèle, ou les transfère dans des mémoires de données. Il peut également les transmettre à d’autres modèles d’analyse. Dans les RDD, les ensembles de données sont divisés en partitions logiques que vous pouvez récupérer, recréer ou modifier, mais aussi calculer à l’aide de transformations et d’actions.

Avec l’offre d’hébergement Linux proposée par IONOS, profitez d’une base de données adaptée à vos besoins, évolutive et flexible, avec un certificat SSL et une protection DDoS, ainsi que des serveurs sécurisés situés dans l’Union Européenne.

DataFrames et DataSets

Spark traite aussi d’autres types de données, appelés « DataFrames » et « Datasets ». Les DataFrames sont des API (Application Programming Interfaces, littéralement « interfaces de programmation d’applications ») qui se présentent comme des tables de données structurées avec des lignes et des colonnes. Les DataSets correspondent à une extension des DataFrames pour une interface utilisateur orientée objet à des fins de programmation. Les DataFrames jouent un rôle essentiel en tant qu’API à la structure uniforme dans tous les langages de programmation, en particulier dans le cadre de la Machine Learning Library (MLlib) de Spark.

Quels sont les langages utilisés par Spark ?

Spark a été développé avec le langage Scala, qui est également le langage primaire du moteur central de Spark. Spark propose en outre des connecteurs Java et Python. Le langage Python combiné à d’autres langages de programmation peut offrir plusieurs avantages en matière d’analyse efficace des données, en particulier dans les domaines de la science et l’ingénierie des données avec Spark. Spark prend aussi en charge les interfaces API de haut niveau pour le langage de programmation R, spécialisé en science des données, qu’il est possible d’appliquer à d’importants volumes de données et d’utiliser dans le cadre de l’apprentissage automatique.

Quels sont les domaines d’utilisation de Spark ?

La diversité des bibliothèques et des mémoires de données Spark, les API compatibles avec nombre de langages de programmation et l’efficacité du traitement en mémoire de Spark lui permet de s’adapter à plusieurs secteurs. Lorsqu’il est question de traiter, d’interroger ou de calculer d’importants volumes de données complexes, Spark propose d’excellentes performances grâce à sa vitesse, à son évolutivité et à sa flexibilité, notamment pour les applications big data des grandes entreprises. Spark est donc tout particulièrement populaire dans les domaines de la publicité numérique et du commerce électronique, dans les entreprises financières, où il est utilisé pour l’analyse de données financières ou la création de modèles d’investissement, ainsi que dans les contextes relevant de la simulation, de l’intelligence artificielle et de la prévision des tendances.

Vous trouverez ci-dessous une liste des aspects parmi les importants pour l’utilisation de Spark :

- Traitement, intégration et collecte de volumes de données provenant d’un grand nombre de sources et d’applications différentes

- Interrogation et analyse interactives de données big data

- Évaluation de la diffusion de données en temps réel

- Apprentissage automatique et intelligence artificielle

- Processus ETL (Extract-Transform-Load, littéralement « extraction, transformation et chargement ») à grande échelle

Vous ne souhaitez pas investir dans un service informatique ? Optez plutôt pour des serveurs dédiés avec des processeurs Intel ou AMD situés dans l’Union Europénne en louant un serveur Managed chez IONOS.

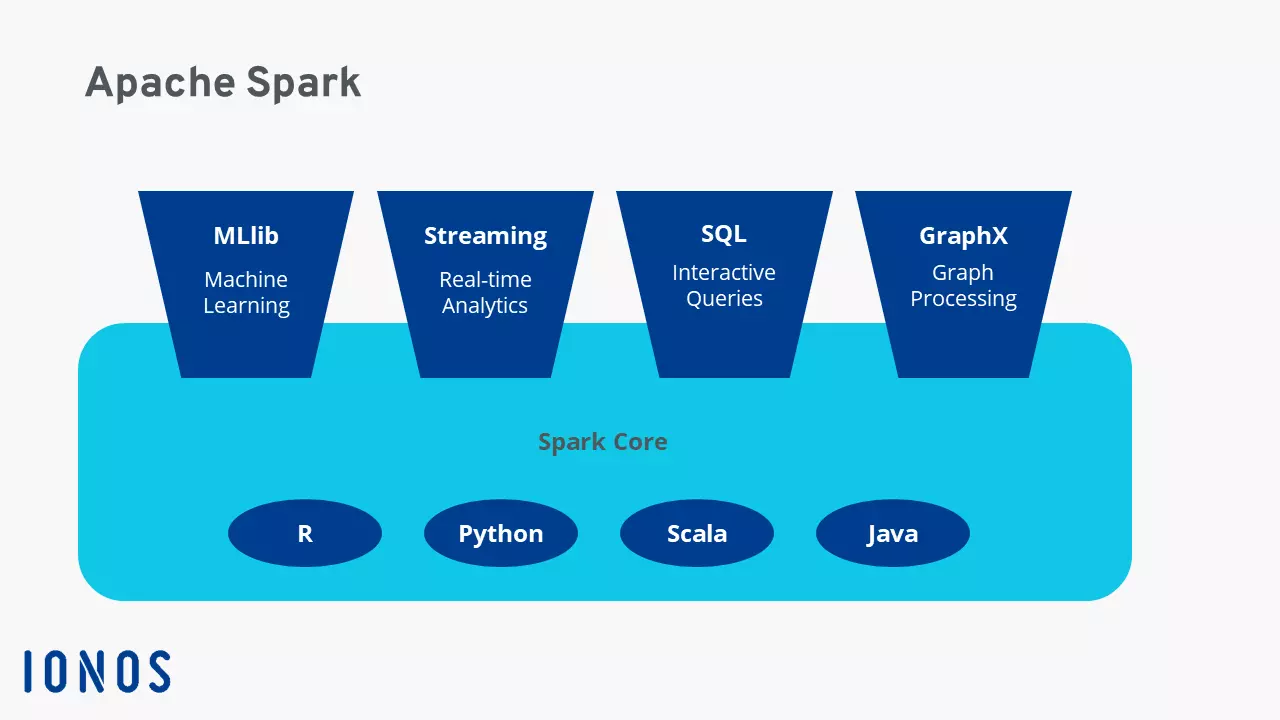

Composants et bibliothèques essentiels de l’architecture Spark

Les éléments ci-dessous comptent parmi les plus importants de l’architecture Spark :

Spark Core

Spark Core sert de base à l’ensemble du système Spark. Il lui fournit ses fonctions de base et gère la répartition des tâches, l’abstraction des données et la planification des déploiements, de même que les processus d’entrée et de sortie. La structure de données de Spark Core se compose de RDD répartis sur plusieurs clusters de serveurs et ordinateurs. Il sert aussi de base à Spark SQL, à des bibliothèques et à Spark Streaming, ainsi qu’à tous les autres composants individuels principaux.

Spark SQL

Cette bibliothèque est tout particulièrement populaire, et permet d’utiliser les RDD en tant que requêtes SQL. Pour ce faire, Spark SQL génère des tables DataFrames temporaires. Spark SQL vous permet d’accéder à différentes sources de données, de travailler avec des données structurées et de faire appel à des requêtes de données en passant par SQL et d’autres API DataFrames. Spark SQL permet en outre d’intégrer le langage du système de base de données HiveQL de manière à accéder à un entrepôt de données géré par Hive.

Spark Streaming

Il s’agit d’une fonctionnalité API de haut niveau qui permet d’utiliser des fonctions de diffusion de données hautement évolutives qui résistent aux pannes, mais aussi de traiter ou d’afficher des flux de données continus en temps réel. Spark génère ensuite des paquets individuels pour les actions sur les données à partir de ces flux. Ainsi, il est également possible d’utiliser des modèles d’apprentissage automatique entraînés dans ces flux de données.

MLlib (Machine Learning Library)

Cette bibliothèque Spark évolutive propose du code en lien avec l’apprentissage automatique pour l’application de processus statistiques avancés dans des clusters de serveurs ou le développement d’applications d’analyse. Elle renferme des algorithmes d’apprentissage courants comme le clustering, la régression, la classification et la recommandation, des services en lien avec le flux de travail, des évaluations de modèles, des statistiques linéaires distribuées et des transformations de l’algèbre ou des caractéristiques. MLlib permet une mise à l’échelle et une simplification efficaces de l’apprentissage automatique.

GraphX

L’API GraphX de Spark permet d’effectuer des calculs de graphiques en parallèle et rassemble l’ETL, le traitement interactif de graphiques et les analyses exploratoires.

Quelle est l’histoire de la création d’Apache Spark ?

Apache Spark a été développé en 2009 sur le campus de l’université de Californie à Berkeley, au sein de l’AMPlab. Depuis 2010, Spark est proposé au public gratuitement, sous licence open source. Depuis 2013, Apache Software Foundation (ASF) continue à développer et à optimiser Spark. Sa popularité et le potentiel de son framework big data ont poussé l’ASF à propulser Stark au rang de « Top-Level Project » (projet de niveau supérieur) en février 2014. Spark 1.0 a été mis à la disposition du public en mai 2014. Aujourd’hui (c’est-à-dire en avril 2023), Spark en est à sa version 3.3.2.

Spark avait pour but d’accélérer les requêtes et les tâches dans les systèmes Hadoop. En se basant sur Spark Core et grâce à des fonctions distribuées pour la transmission de tâches, des fonctionnalités d’entrée et de sortie et des possibilités de traitement en mémoire, il a largement devancé MapReduce, qui représentait jusqu’alors la norme dans le framework Hadoop.

Quels sont les avantages d’Apache Spark ?

Pour interroger et traiter rapidement d’importants volumes de données, Spark propose les avantages suivants :

- Vitesse : il peut traiter et exécuter les charges de travail jusqu’à cent fois plus rapidement que MapReduce (créé par Hadoop). D’autres avantages en matière de performance sont en lien avec la prise en charge du traitement par lots et du traitement des données de flux, des graphiques acycliques orientés, d’un moteur d’exécution physique et de solutions d’optimisation des requêtes.

- Évolutivité : avec le traitement en mémoire des données réparties sur les différents clusters, Spark vous propose de faire évoluer les ressources de manière flexible en fonction de vos besoins.

- Cohérence : Spark agit comme un framework global pour le big data, qui rassemble différentes fonctions et bibliothèques au sein d’une seule application : requêtes SQL, DataFrames, Spark Streaming, MLlib (pour l’apprentissage automatique) GraphX (pour le traitement des graphiques), etc., sans oublier l’intégration de HiveQL.

- Facilité d’utilisation : grâce à des interfaces API conviviales donnant accès à d’innombrables sources de données et à plus de 80 opérateurs courants pour le développement d’applications, Spark réunit en un seul framework un grand nombre de possibilités d’application. L’utilisation interactive de shells Scala, Python, R ou SQL pour l’écriture de services peut également s’avérer particulièrement intéressante.

- Framework open source : autour de son approche open source, Spark a su réunir une communauté internationale et active de spécialistes qui le développent en permanence, remédient à ses vulnérabilités en matière de sécurité et assurent une innovation rapide.

- Optimisation de l’efficacité et réduction des coûts : Comme Spark n’a pas besoin de structures de serveurs physiques haut de gamme pour fonctionner, la plateforme d’analyse big data propose des fonctionnalités permettant à la fois de réduire les coûts et d’améliorer les performances, en particulier dans le domaine des algorithmes d’apprentissage automatique à forte intensité de calcul et des processus de données complexes en parallèle.

Quels sont les inconvénients d’Apache Spark ?

S’il présente de nombreux points forts, Spark n’est toutefois pas totalement dénué d’inconvénients. Spark ne dispose d’aucun moteur de mémoire intégré ; il est donc dépendant de plusieurs composants distribués. En outre, comme le traitement en mémoire nécessite beaucoup de mémoire vive, vos performances peuvent être amoindries si vous ne disposez pas de suffisamment de ressources. Vous devrez donner de votre temps pour vous former à l’utilisation de Spark et comprendre les processus qui sous-tendent la configuration d’un serveur Web Apache autonome ou d’autres structures de Cloud par l’intermédiaire de Spark.