WordPress et robots.txt : configuration du fichier

Les sous-pages et les répertoires de votre site ne sont pas importants au point de devoir nécessairement tous être explorés par les moteurs de recherche courants. À l’aide du fichier robots.txt, vous pouvez déterminer quelles sous-pages de WordPress doivent être prises en compte par le robot d’exploration et lesquelles ne le doivent pas. Vous améliorez ainsi considérablement le positionnement de votre site Web dans les recherches en ligne. Nous vous expliquons ici à quoi sert le fichier robots.txt dans WordPress et comment l’optimiser vous-même.

- Domaine .eu ou .fr + éditeur de site gratuit pendant 6 mois

- 1 certificat SSL Wildcard par contrat

- Boîte email de 2 Go

Qu’est-ce que robots.txt pour WordPress ?

24 heures sur 24, des robots d’exploration parcourent Internet à la recherche de sites Web. Les robots sont envoyés par chaque moteur de recherche et saisissent le plus grand nombre possible de pages et de sous-pages (indexation) afin de les rendre disponibles pour la recherche. Pour que les robots d’exploration puissent bien lire votre site, ils doivent être guidés. Vous éviterez ainsi d’indexer des contenus de votre site qui ne sont pas pertinents pour les moteurs de recherche et vous vous assurerez que le robot d’exploration ne lit que les contenus qu’il doit lire.

Pour ce contrôle, vous pouvez utiliser le fichier robots.txt. Dans le cas de WordPress et d’autres CMS, vous déterminez avec ce fichier quelles parties de votre site Web sont saisies par les crawlers et lesquelles ne le sont pas. Le fichier robots.txt vous permet d’exclure ou d’autoriser les robots et de faire des distinctions précises entre les entrées qui doivent être trouvées par les moteurs et les autres, et qui les diffusent ensuite dans la recherche. Comme chaque domaine ne dispose que d’un budget d’exploration limité, il est d’autant plus important de pousser les pages principales et de retirer les sous-pages insignifiantes du volume de recherche.

Le domaine de vos rêves en seulement quelques étapes ! Enregistrez facilement votre domaine idéal chez IONOS et profitez d’un excellent service, de nombreuses fonctions de sécurité et d’une boîte email de 2 Go.

À quoi sert le fichier robots.txt dans WordPress ?

Il y a de grands avantages à ce que le fichier robots.txt de WordPress détermine exactement quels contenus sont indexés et lesquels ne le sont pas. Alors que votre page d’accueil doit être bien classée pour toutes les recherches possibles, il n’en va pas de même pour les mentions légales de votre site. Les commentaires ou les archives n’apportent pas non plus de valeur ajoutée dans la recherche et peuvent même, au contraire, présenter des inconvénients, lorsque les moteurs de recherche reconnaissent ici le duplicate Content et l’évaluent négativement, par exemple. Avec un fichier robots.txt sur WordPress, vous excluez au mieux de tels cas et dirigez plutôt les différents robots d’exploration vers les parties de votre site qui doivent vraiment être trouvées.

Le fichier robots.txt automatique de WordPress

Au début, WordPress crée lui-même un fichier robots.txt et effectue ainsi le travail préparatoire de base. Toutefois, celui-ci est peu étendu et doit donc être considéré avant tout comme un point de départ. Voici à quoi il ressemble :

User-agent: *

Disallow: /wp-admin/

Disallow: /wp-includes/L’« user-agent » de la première ligne désigne ici les crawlers. « * » exprime que tous les moteurs de recherche peuvent envoyer leurs robots sur votre site. C’est en principe recommandé dans un premier temps, car cela permet à votre site d’être trouvé plus souvent. La commande « Disallow » bloque les répertoires suivants pour les robots d’exploration – dans ce cas, il s’agit de l’administration et du répertoire de tous les fichiers chez WordPress. Robots.txt les bloque pour les moteurs de recherche, car les visiteurs n’ont rien à faire sur les pages concernées. Afin d’être effectivement la seule personne à pouvoir y accéder, protégez ces domaines par un bon mot de passe.

En tant qu’administrateur, vous pouvez également protéger votre connexion WordPress en utilisant le fichier .htaccess.

Que doit contenir un fichier robots.txt sur WordPress ?

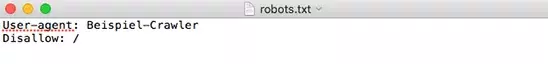

Les moteurs de recherche comme Google doivent bien sûr continuer à trouver facilement votre site. Les services réputés nuisibles ou douteux comme DuggMirror ne le doivent toutefois pas ; vous pouvez les exclure de WordPress avec robots.txt. Pour cela, vous devez exclure de l’indexation les thèmes, vos mentions légales et les pages qui n’ont pas ou peu de pertinence. Les plugins ne devraient pas non plus être indexés, non seulement parce qu’ils ne sont pas pertinents pour le public, mais aussi pour des raisons de sécurité. Si un plugin présente un problème de sécurité, votre site peut être de cette manière trouvé et endommagé par des pirates.

Dans la plupart des cas, les deux commandes déjà mentionnées ci-dessus vous suffiront pour utiliser judicieusement robots.txt sur WordPress : « User-agent » détermine auprès de quels bots il faut s’adresser. Vous pouvez ainsi définir des exceptions pour certains moteurs de recherche ou établir des règles de base. « Disallow » interdit aux robots d’exploration l’accès à une page ou sous-page correspondante. La troisième commande « Allow » n’a pas d’importance dans la plupart des cas, car l’accès est autorisé par défaut. Vous n’avez besoin de cette commande que si vous souhaitez bloquer une page mais débloquer son sous-site.

Le moyen le plus rapide de créer son propre site Web : l’hébergement Wordpress de IONOS séduit par ses nombreux avantages. SSD, HTTP/2 et gzip sont également inclus, tout comme trois domaines gratuits en permanence. Choisissez le modèle tarifaire qui vous convient le mieux !

Modifier manuellement le fichier Robots.txt sur WordPress

Pour des adaptations individuelles, il est bon d’élargir soi-même le robots.txt de WordPress. Pour cela, il suffit de suivre quelques étapes simples.

Étape 1 : tout d’abord, créez un fichier vide appelé « robots.txt » dans un éditeur de texte quelconque.

Étape 2 : vous les téléchargez ensuite dans le répertoire racine de votre domaine.

Étape 3 : vous pouvez maintenant modifier le fichier via SFTP ou télécharger un nouveau fichier texte.

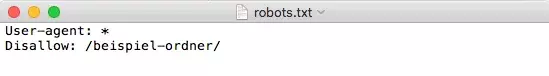

Avec les commandes expliquées ci-dessus, vous contrôlez maintenant les règles et les exceptions qui s’appliquent à votre site Web. Comment bloquer l’accès à un dossier spécifique :

Plugins pour la création d’un fichier robots.txt sur WordPress

Vous pouvez également créer et modifier le fichier robots.txt sur WordPress avec un plugin SEO. Cela se fait très facilement et en toute sécurité dans le tableau de bord et peut donc être encore plus simple. Un plugin populaire à cet effet est Yoast SEO.

Étape 1 : vous devez d’abord installer et activer le plugin.

Étape 2 : permettez ensuite au plugin d’effectuer des modifications avancées. Pour cela, allez sur « SEO » > « Tableau de bord » > « Fonctionnalités » et cliquez sur « Activés » sous le point « Paramètres avancés de la page ».

Étape 3 : après cette activation, effectuez des modifications dans le tableau de bord sous « SEO » > « Outils » > « Éditeur de fichiers ». Vous pouvez y créer et modifier directement un nouveau fichier robots.txt sur WordPress. Les modifications sont ensuite directement mises en œuvre.

Comment tester les changements ?

Maintenant que vous avez configuré votre site, que vous avez fixé des règles et que vous avez, en théorie du moins, bloqué les robots d’indexation et rendu les sous-pages invisibles, il est temps de passer à l’action. Mais comment savoir si toutes vos modifications ont bien été effectuées ? Pour cela, consultez l’aide de Google Search Console. Dans celle-ci, vous trouverez sur le côté gauche sous « Crawl » le « robots.txt Tester ». Vous y saisissez vos pages et sous-pages et voyez ensuite si elles peuvent être trouvées ou si elles sont bloquées. Un « autorisé » en vert en bas à droite signifie que les crawlers trouvent la page et la prennent en compte, un « non autorisé » en rouge signifie que la page n’est pas indexée.

En résumé : robots.txt optimise et protège votre site Web

Le fichier robots.txt est pour WordPress une méthode aussi simple qu’efficace pour déterminer quelles parties de votre site doivent être trouvées et par qui. Si dans tous les cas vous utilisez déjà un plugin SEO comme Yoast, le plus simple est de l’utiliser pour effectuer les modifications. Sinon, le fichier peut aussi être créé et adapté manuellement sans problème.

Dans le guide digital de IONOS, vous trouverez de précieux conseils sur le thème de WordPress. Nous vous aidons à éviter les erreurs WordPress les plus fréquentes, nous vous expliquons comment rendre WordPress plus rapide et comment utiliser Gutenberg de WordPress. Vous êtes sûr de trouver des réponses adaptées ici.